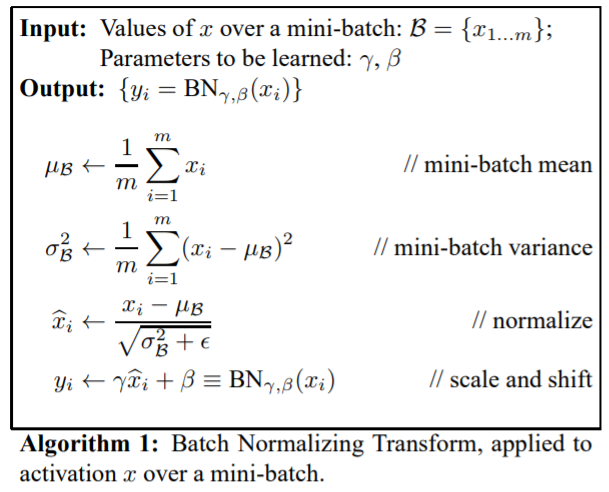

Batch normalization과 Input normalization은 모두 데이터 정규화 기술이지만, 방식과 적용되는 시점에서 차이가 있다. 1) Batch normalization Batch normalization은 각 mini batch의 평균과 표준편차를 계산하고, 이를 사용하여 입력을 정규화하는 방식이다. normalization 작업이 별도의 과정으로 떼어진 것이 아니라 신경망 안에 포함되어, normalization 작업 역시 학습과정에서 같이 조절되게 된다. 즉, 각 레이어마다 정규화하는 레이어를 두어, 변형된 분포가 나오지 않도록 조절하는 것이 batch normalization이다. normalization 작업 역시 학습 과정에서 조절된다. 따라서 위의 식에서 베타와 감마는 학습..