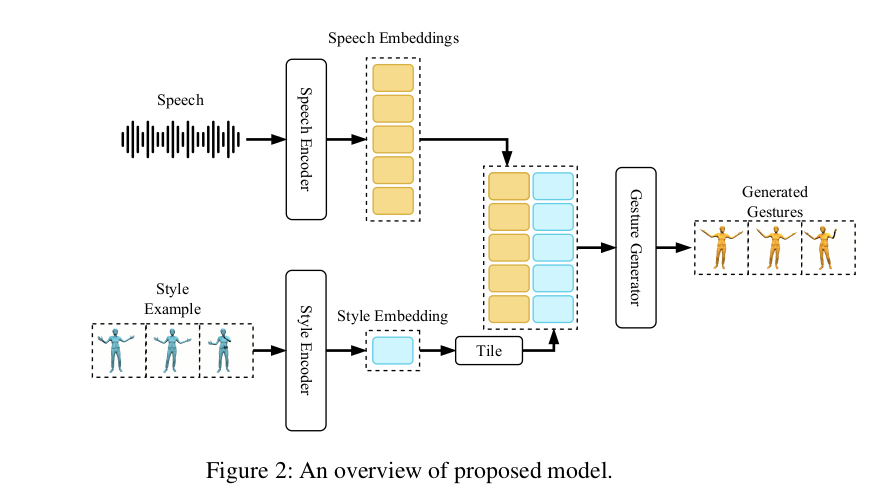

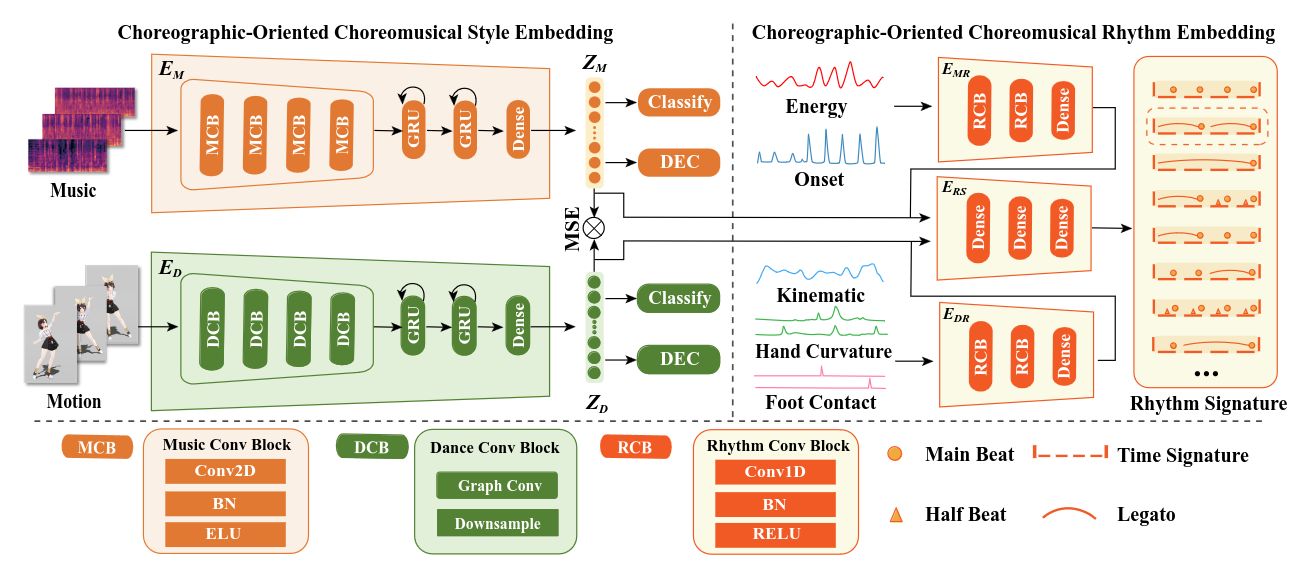

6. Limitation diffusion model을 사용하다보니 느린 것이 가장 문제임. 오디오 기반 모션 생성의 품질을 개선하는 것이며 오프라인 생성에 중점을 두고 있으므로 합성 속도를 최적화하는 것에는 어떤 노력도 기울이지 않았음. 실시간 상호작용이나 게임 엔진 통합에는 적절하지 않음 그리고 의도적인 제스처와 dancing에 필요한 모든 측면을 다 capture하지는 못함. gesture의 경우에는 음성의 의미를 이해하고 gesture를 생성하지는 못함 dance의 경우에도 저차원의 음성 데이터를 넣어주기 때문에 구조적인것만 고려해서 dance를 만들어내게 됨 그리고 각 expert network가 확률적 분포의 교차점에 집중하여 모션을 만들어내는게 강점일수도 있고 약점일수도 있음. 수학적으로는 ..